网上搏彩新葡京

前 言:

当前,在算力、算法和大数据三驾马车的支撑下,全球人工智能进入第三次爆发期。然而,作为引爆点的深度学习算法,对现有的算力尤其是芯片提出了更为苛刻的要求。

在AI场景中,传统通用CPU由于计算效率低难以适应AI计算要求,GPU、FPGA以及ASIC等AI芯片凭借着自身特点,要么在云端,要么在边缘端,有着优异表现,应用更广。

从技术趋势看,短期内GPU仍将是AI芯片的主导,长期看GPU、FPGA以及ASIC三大技术路线将呈现并行态势。

从市场趋势看,全球AI芯片需求将保持较快增长势头,云端、边缘芯片均具备较大增长潜力,预计未来5年市场增速将接近50%;国内虽然芯片技术差距较大,但随着AI应用的快速落地,AI芯片需求增长可能更为迅速。

▌人工智能芯片发展现状及趋势

深度学习算法对芯片要求更为苛刻,通用CPU性价比相对较差

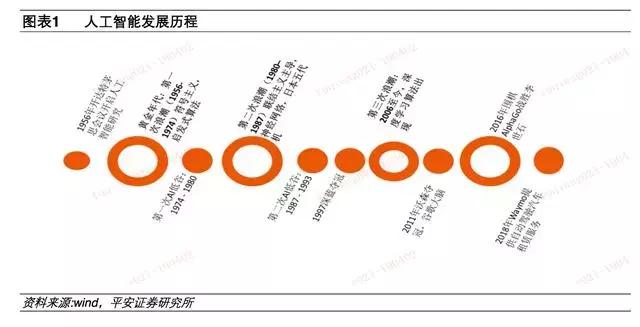

经历了60多年的起起伏伏之后,人工智能终于迎来了第三次爆发。

第三次爆发的核心引爆点是深度学习算法的出现,但其背后的支撑是数据和算力。对整个AI行业来讲,算法、数据和算力三大基本要素中,数据尤其是海量数据的获取和处理难度在下降,算法也在深度学习模型的基础上不断优化,而负责将数据和深度算法统一协调起来的芯片能否获得大的飞跃,成为市场关注的焦点。

深度学习算法对芯片性能需求主要表现在三个方面:

1.海量数据在计算和存储单元之间的高速通信需求。这不但需要芯片具备强大的缓存和片上存储能力,而且还需要计算和存储单元之间有较大的通信带宽。

2.专用计算能力需求高。深度学习算法中有大量卷积、残差网络、全连接等特殊计算需要处理,还需要提升运算速度,降低功耗。

3.海量数据自身处理同样也对芯片提出了新的要求,尤其是非结构化数据的增多,对传统芯片结构造成了较大的压力。

通用CPU在深度学习中可用但效率较低。比如在图像处理领域,主要用到的是CNN(卷积神经网络),在自然语言识别、语音处理等领域,主要用到的是RNN(循环神经网络),虽然这两种算法模型有着较大的区别,但本质上都是向量和矩阵运算,主要是加法和乘法,辅助一些除法和指数运算。

传统CPU可用于做上述运算,但是CPU还有大量的计算逻辑控制单元,这些单元在AI计算中是用不上的,造成了CPU在AI计算中的性价比较低。

关注乐晴智库 ( 网站:www.767stock.com,公众号ID: lqzk767) 获取更多深度行业研究报告。

GPU、FPGA以及ASIC各有优劣,成为当前AI芯片行业的主流

正因为CPU在AI计算上的弱点,给了可以实现海量并行计算且能够对进行计算加速的AI芯片留下了市场空间。

从广义上讲,面向AI计算的芯片都可以称为AI芯片,包括基于传统架构的GPU、FPGA以及ASIC(专用芯片),也包括正在研究但离商用还有较大差距的类脑芯片、可重构AI芯片等。

云端训练芯片市场较为集中,而推理市场云、边两端均有大量企业参与按照部署位置划分,AI芯片可以分为云端芯片和边缘端芯片。

云端芯片部署位置包括公有云、私有云或者混合云等基础设施,主要用于处理海量数据和大规模计算,而且还要能够支持语音、图片、视频等非结构化应用的计算和传输,一般情况下都是用多个处理器并行完成相关任务;

边缘端AI芯片主要应用于嵌入式、移动终端等领域,如摄像头、智能手机、边缘服务器、工控设备等,此类芯片一般体积小、耗电低,性能要求略低,一般只需具备一两种AI能力。

按照承担的任务分,AI芯片可以划分为训练芯片和推理芯片。

训练是指通过大量标记过的数据在平台上进行“学习”,并形成具备特定功能的神经网络模型;推理则是利用已经训练好的模型输入新数据通过计算得到各种结论。

训练芯片对算力、精度要求非常之高,而且还需要具备一定的通用性,以适应多种算法的训练;推理芯片更加注重综合能力,包括算力能耗、时延、成本等因素。