缩水号怎么投注

选自 arXiv

作者:Honghua Dong 等

深度神经网路一直被人诟病的地方在于,缺少逻辑推理能力,它只是一种函数拟合方法。在这篇论文中,清华、谷歌和字节跳动的研究者提出了一种名为神经逻辑机的模型,它可同时用于归纳学习与逻辑推理。它结合神经网络与逻辑程序设计(逻辑编程),让神经网络也能用于逻辑推理。

这篇论文被接受为 ICLR 2019 的 Poster,它的评分为 6、5、7。正如评审该论文的领域主席所言,这篇论文提出了一个非常有意思的正向链模型,它利用了元层级的扩展,并以一种非常简洁的方式降低了谓项参数,从而降低了复杂度。

- 论文链接:https://arxiv.org/abs/1904.11694

- 演示地址:https://sites.google.com/view/neural-logic-machines

在该论文的展示页中,作者们也介绍了各种任务的效果,包括排序、最短路径搜索和积木世界等。其中所有智能体都通过强化学习训练,智能体会根据当前状态迭代地选择动作,直到一个 Episode 结束。

下面我们简要展示神经逻辑机(NLM)在最短路径搜索和积木世界上的表现。

1. 最短路径搜索

该任务会随机生成一个无向图,智能体需要从开始节点一步步走到目标结点。例如如果我们将初始结点定义为 s、目标结点定义为 t,那么 s 到 t 之间的距离为 d,d 是从区间 [1, 5] 中均匀采样的。

结果是,NLM 智能体能搜索到最短路径。

2. 积木世界

该任务有两个世界,即操作世界(operating world)和目标世界,下面视频分别展示在上面和下面两部分。每一个世界包含 n 个积木,该任务的目标,即采取一系列动作将初始的操作世界转换为目标世界。

结果是,智能体能搜索到正确的积木移动顺序,并将初始状态转化为目标状态。

什么是「学习」解决不了的

机器学习已经成功应用在语音识别、游戏等诸多领域,但联结主义模型的系统性(systematicity)问题仍然存在争议。

逻辑系统可以自然地处理语言理解和推理中的符号规则。归纳逻辑程序设计(ILP)从例子中学习逻辑规则。粗略地说,给定一组正负样本,ILP 系统可以学习一组规则(带有不确定性),其中包含所有正样本,而不含负样本。将符号和概率结合起来,可以很自然地解决许多高级认知能力(如系统性)带来的问题。然而,由于组合规则(compositional rule)的搜索空间巨大,ILP 很难扩展到小型规则集合之外。

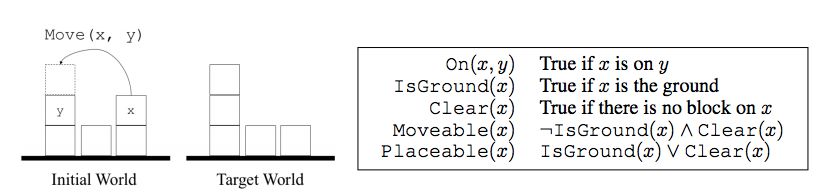

为了更加具体地讨论,该研究以经典的积木世界(blocks world)问题为例。如图 1 所示,给定一堆积木,我们可以移动一块积木 x 并将其放在另一块积木 y 的上方或地上,前提是 x 可以移动并且 y 上可以放积木。我们将这种操作称之为 Move(x, y)。如果一块积木上没有其他的积木,那么这块积木就是可以移动的,而且上面可以放其他积木。地上一直可以放积木,也就是说我们可以把所有积木都放在地上。给定积木世界的初始状态之后,我们的目标就是通过一系列移动操作将其转换为目标状态。

图 1:(左)积木世界图示。给出原始和目标状态,要求智能体通过移动积木将原始状态转换为目标状态。(右)本文用到的积木世界术语。

虽然积木世界问题乍看之下非常简单,但构建学习系统来自动完成此任务存在四大挑战: